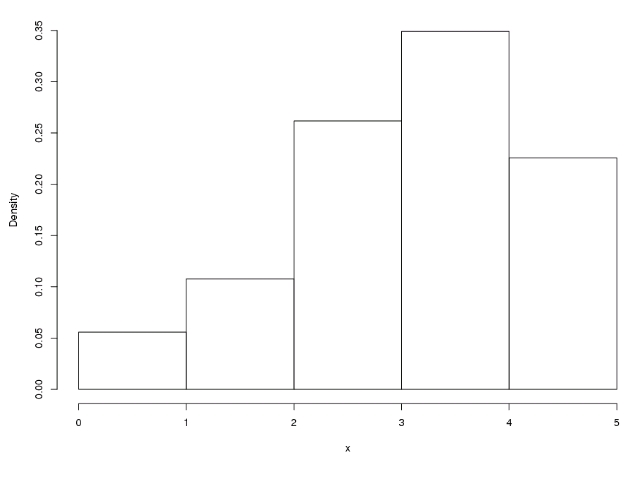

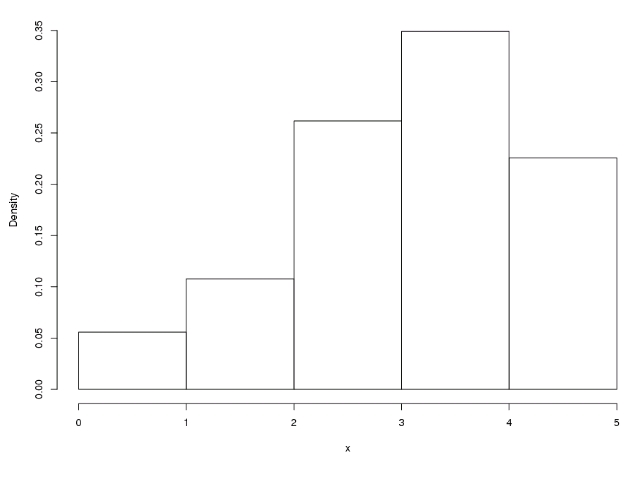

사용자의 점수 분포도 netflix prize/일지2008. 3. 23. 09:38

어째서 , 어째서 , 분산을 좌, 우 따로 생각했을때는 값이 시원찮을까.?

| RMSE | K | Beta | Alpha | naïve average | average | OverRangeCnt | BelowRangeCnt |

| 1.086715 | 20 | 500 | 1 | 0.000000 | x | x | |

| 1.087711 | 20 | 500 | 5 | 3.811471 | x | x | |

| 1.066420 | 20 | 500 | 5 | 3.772584 | x | x | |

| 1.062754 | 15 | 500 | 5 | 3.763922 | x | x | |

| 1.060523 | 10 | 500 | 5 | 3.751026 | x | x | |

| 1.059561 | 10 | 500 | 5 | 3.671148 | x | x | |

| 1.058549 | 10 | 500 | 5 | 3.671544 | x | x | |

| 1.082158 | 10 | 50 | 5 | 3.679396 | x | x | |

| 1.043956 | 10 | 1000 | 5 | 3.669001 | x | x | |

| 0.999239 | 10 | 5000 | 5 | 3.672115 | 61274 | 1823 | |

| 0.977306 | 10 | 10000 | 5 | 3.671869 | 33801 | 1240 | |

| 0.960570 | 10 | 20000 | 5 | 3.672174 | 16041 | 793 | |

| 0.951201 | 10 | 40000 | 5 | x | 8467 | 631 | |

| 0.946785 | 10 | 80000 | 5 | 3.673125 | 4348 | 607 | |

| 0.944558 | 10 | 160000 | 5 | 3.579016 | 3.673185 | 1700 | 588 |

| 0.944167 | 10 | 240000 | 5 | 3.582144 | 3.673198 | 704 | 582 |

| 0.946210 | 10 | 240000 | 10 | 3.583814 | 3.673236 | 704 | 551 |

| 0.943102 | 10 | 240000 | 1 | 3.579747 | 3.673172 | 702 | 605 |

| 0.944175 | 10 | 320000 | 5 | 3.584546 | 3.673181 | 287 | 576 |

| 0.944596 | 10 | 480000 | 5 | 3.587935 | 3.673000 | 18 | 568 |

| 0.945135 | 10 | 640000 | 5 | 3.590200 | 3.673006 | 1 | 568 |

| 0.948938 | 20 | 240000 | 1 | 3.634656 | 3.673611 | 1187 | 282 |

| 0.950472 | 20 | 320000 | 1 | 3.638476 | 3.673582 | 728 | 277 |

| 0.947117 | 20 | 160000 | 1 | 3.629352 | 3.673597 | 2206 | 290 |

| 0.945321 | 20 | 80000 | 1 | 3.621160 | 3.673425 | 4868 | 303 |

| 0.946892 | 20 | 40000 | 1 | 3.615978 | 3.673165 | 9207 | 329 |

| 0.952628 | 20 | 320000 | 1 | 3.638476 | 3.638590 | 728 | 277 |

| qualifying set. | |||||||

| 20 | 80000 | 1 | 3.616442 | 9908 | 1773 |

netflix prize research day 27~31

이번 한주동안 한일은 다음과같다. (매우 많은데 이렇게 보니 또 별거 없어보인다.)

UserRating구조체는 bitfield를 사용하여 1바이트 압축. MovieRating역시 1바이트. (날짜 데이터를 제외시켰다.)

moviedata_set을 저장할때 userScaled를 키값으로 정렬되도록 하였다.

TODO

global effect구현netflix prize research day 26_2

오늘 한일은 다음과같다

TODO

각 유져와 무비 페어에 대해.

• N(i;u)를 구한다. 즉 u가 rating했던 아이템중 i와 비슷한 아이템 20개를 선정한다.(20이 안되는 경우는 assert걸어둔다.)

• 20 * 20 매트릭스 A, 20 * 1 벡터 b를 작성하고, 알고리즘을 이용하여 w를 구한다. (->여기서 문제가 발생하고 있다. length가 점점 커지다가 조건에 걸려서 종료되어야 하는데, length는 갈수록 작아져만 간다...) => K값을 줄인후 알고리즘을 하나하나 추적하여 뭐가 잘못된지 발견해내자.

• ProbeReader를 이용하여 probeset을 읽고 정답을 채우자.

* 정답을 채워넣는 클래스도 만들어내면 편할 듯.

- 통계프로그램을 구했으니 슬슬 자료 분석도 시작해 봐야지

netflix prize research day 26

오늘 한일은 다음과같다

TODO

각 유져와 무비 페어에 대해.

• N(i;u)를 구한다. 즉 u가 rating했던 아이템중 i와 비슷한 아이템 20개를 선정한다.(20이 안되는 경우는 assert걸어둔다.)

• 20 * 20 매트릭스 A, 20 * 1 벡터 b를 작성하고, 알고리즘을 이용하여 w를 구한다. (->여기서 문제가 발생하고 있다. length가 점점 커지다가 조건에 걸려서 종료되어야 하는데, length는 갈수록 작아져만 간다...) => K값을 줄인후 알고리즘을 하나하나 추적하여 뭐가 잘못된지 발견해내자.

• 레이팅을 채운다..

- 통계프로그램을 구했으니 슬슬 자료 분석도 시작해 봐야지

netflix prize research day 26

오늘 한일은 다음과같다

이를 위해서 오늘

TODO

각 유져와 무비 페어에 대해.

• N(i;u)를 구한다. 즉 u가 rating했던 아이템중 i와 비슷한 아이템 20개를 선정한다.(20이 안되는 경우는 assert걸어둔다.)

• 20 * 20 매트릭스 A, 20 * 1 벡터 b를 작성하고, 알고리즘을 이용하여 w를 구한다.

• 레이팅을 채운다..

- 통계프로그램을 구했으니 슬슬 자료 분석도 시작해 봐야지

netflix prize research day 19 ~ 25

일본여행을 1월29일부터 2월 1일까지 3박 4일로 다녀오는 바람에 제대로 한게 아무것도 없다.

다만 이전에 계산해 두었던 매트릭스 A^ 를 읽어보니 nan이 무척이나 많아서 당황..

TODO

각 유져와 무비 페어에 대해.

• N(i;u)를 구한다. 즉 u가 rating했던 아이템중 i와 비슷한 아이템 20개를 선정한다.(20이 안되는 경우는 assert걸어둔다.)

• 20 * 20 매트릭스 A, 20 * 1 벡터 b를 작성하고, 알고리즘을 이용하여 w를 구한다.

• 레이팅을 채운다..

- 통계프로그램을 구했으니 슬슬 자료 분석도 시작해 봐야지